前提知識ニューラルネットワーク Python

■LLMとは

LLM(Large Language Model:大規模言語モデル)とは、大量の文章データを用いて学習された人間の言語を理解・生成するための人工知能モデルです。

文章を単語やトークンと呼ばれる最小単位に分解し、それらの並び方の統計的な傾向を学習することで「次に来そうな語」を高い精度で予測します。

この仕組みにより、質問応答/文章要約/翻訳/プログラム生成など、幅広いタスクを一つのモデルで柔軟にこなせる点が特徴です。ニューラルネットワーク 構造が用いられ、

Self-Attention機構によって文脈全体を考慮しながら処理を行うのが特徴です。

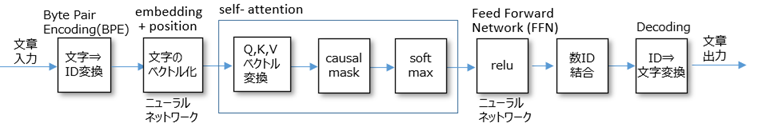

■LLMの基本構造

BPE(Byte Pair Encoding) Embedding + positioning Word2Vec がありますが、

ここではニューラルネットワークを用いて、意味的に近い値を学習できるようにします。Self-Attention FFN(Feed Forward Network)

■LLM理解のための最小コード

上記構造を再現したコードが以下となります。ただしBPEは含まれてません。

import torch### Vocabulary ### "]### Model parameters ### ### GPT Forward ### # ---- Self-Attention ---- # ---- FFN ---- ### Training data ### "### Optimizer & Loss ### ### Training loop ### ### Autoregressive generation ### ":### Run ###

サブチャンネルあります。⇒ 何かのお役に立てればと