情報量のエントロピーとは |

|||||||

・エンコード,デコード ・ハッシュ関数 ・暗号化の仕組み ・青空文庫の本文抽出 ・形態素解析 ・単語にIDを付与し辞書作成 ・Bag Of Words(BOW) ・Word2Vec ・画像フィルタ ・アフィン変換 ・スクレイピングとは ・webの画像ダウンロード ・malformed AAC bitstream |

前提知識

■情報量のエントロピーとは

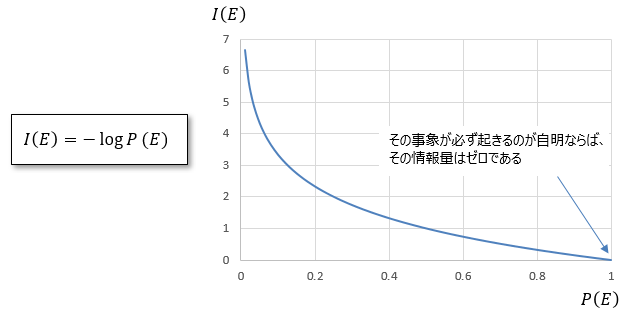

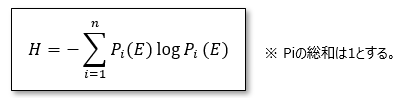

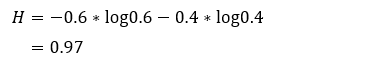

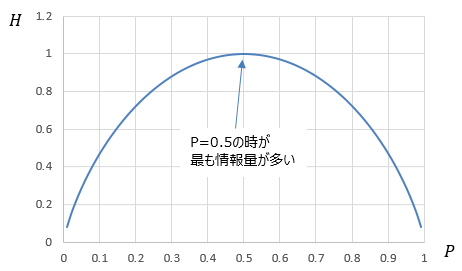

情報理論におけるエントロピーとは、その情報がどれくらいの情報量を持っているか表す指標で、平均情報量ともいわれています。

エントロピーとは「均質化」「一様化」という意味を持っており、情報が一様化であるならばエントロピーは小さいと言えます。

サブチャンネルあります。⇒ 何かのお役に立てればと

|

|

|||||